Com os avanços da eletrônica e da neurociência, os pesquisadores conseguiram alcançar coisas notáveis com os dispositivos de implante do cérebro, como a restauração de uma aparência de visão para os cegos. Além de restaurar os sentidos físicos, os cientistas também estão buscando formas inovadoras de facilitar a comunicação para aqueles que perderam a capacidade de falar. Um novo "decodificador" que recebe dados de eletrodos implantados dentro do crânio, por exemplo, pode ajudar pacientes paralisados a falar usando apenas suas mentes.

Pesquisadores da Universidade da Califórnia, San Francisco (UCSF) desenvolveram um método de dois estágios para transformar sinais cerebrais em fala sintetizada por computador. Seus resultados, publicados esta semana na revista científica Nature, fornecem um caminho possível para uma comunicação mais fluida para pessoas que perderam a capacidade de falar.

Por anos, os cientistas têm tentado aproveitar as informações neurais para dar voz a pessoas cujo dano neurológico as impede de falar - como sobreviventes de derrame ou pacientes com ELA. Até agora, muitas dessas interfaces cérebro-computador apresentam uma abordagem letra por letra, na qual os pacientes movem seus olhos ou músculos faciais para soletrar seus pensamentos. (Stephen Hawking dirigiu seu sintetizador de fala com pequenos movimentos em sua bochecha).

Mas esses tipos de interfaces são lentos - a maioria produz 10 palavras por minuto, uma fração da velocidade média de 150 palavras por minuto dos falantes. Para uma comunicação mais rápida e fluida, os pesquisadores da UCSF usaram algoritmos de aprendizagem profunda para transformar sinais neurais em sentenças faladas.

“O cérebro está intacto nesses pacientes, mas os neurônios - os caminhos que levam aos braços, à boca ou às pernas - são quebrados. Essas pessoas têm alto funcionamento cognitivo e habilidades, mas não podem realizar tarefas diárias como se movimentar ou dizer qualquer coisa ”, diz Gopala Anumanchipalli, co-autor do novo estudo e pesquisador associado especializado em cirurgia neurológica na UCSF. "Estamos essencialmente ignorando o caminho que está quebrado."

Os pesquisadores começaram com dados de atividade cerebral de alta resolução coletados de cinco voluntários durante vários anos. Esses participantes - todos com função de fala normal - já estavam passando por um processo de monitoramento para tratamento de epilepsia que envolvia implantar eletrodos diretamente em seus cérebros. A equipe de Chang usou esses eletrodos para rastrear a atividade em áreas relacionadas ao discurso do cérebro, enquanto os pacientes liam centenas de frases.

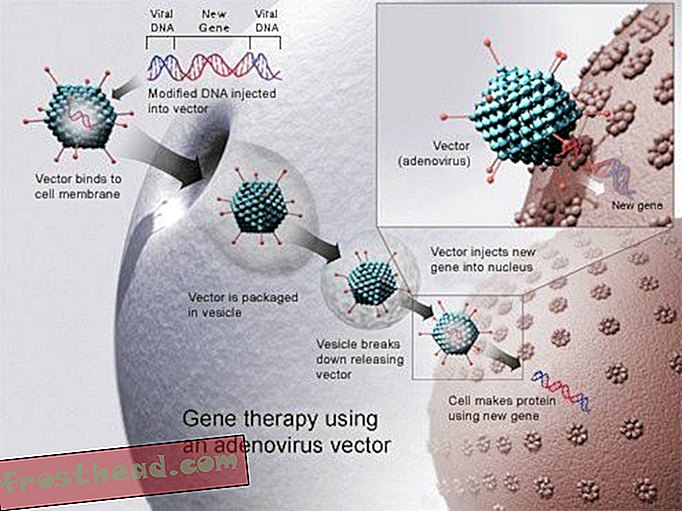

A partir daí, a equipe da UCSF elaborou um processo em duas etapas para recriar as frases faladas. Primeiro, eles criaram um decodificador para interpretar os padrões de atividade cerebral registrados como instruções para mover partes de um trato vocal virtual (incluindo os lábios, a língua, a mandíbula e a laringe). Eles então desenvolveram um sintetizador que usava os movimentos virtuais para produzir linguagem.

Outra pesquisa tentou decodificar palavras e sons diretamente de sinais neurais, ignorando o passo intermediário do movimento de decodificação. No entanto, um estudo que os pesquisadores da UCSF publicaram no ano passado sugere que o centro de fala do seu cérebro se concentra em como mover o trato vocal para produzir sons, ao invés do que os sons resultantes serão.

"Os padrões de atividade cerebral nos centros de fala são especificamente voltados para coordenar os movimentos do trato vocal, e apenas indiretamente ligados aos próprios sons da fala", disse Edward Chang, professor de cirurgia neurológica na UCSF e coautor do novo artigo, disse em uma entrevista coletiva esta semana. "Estamos explicitamente tentando decodificar movimentos para criar sons, em vez de decodificar diretamente os sons."

Um exemplo de arranjo de implante cerebral de eletrodos intracranianos do tipo usado para registrar a atividade cerebral. (UCSF)

Um exemplo de arranjo de implante cerebral de eletrodos intracranianos do tipo usado para registrar a atividade cerebral. (UCSF) Usando esse método, os pesquisadores criaram, com sucesso, palavras e frases de engenharia reversa a partir de atividades cerebrais que, grosso modo, correspondiam às gravações de áudio da fala dos participantes. Quando eles pediram voluntários em uma plataforma online de crowdsourcing para tentar identificar as palavras e transcrever frases usando um banco de palavras, muitos deles puderam entender o discurso simulado, embora sua precisão estivesse longe de ser perfeita. De 101 sentenças sintetizadas, cerca de 80% foram perfeitamente transcritas por pelo menos um ouvinte usando um banco de 25 palavras (essa taxa caiu para cerca de 60% quando o tamanho do banco de palavras dobrou).

É difícil dizer como esses resultados se comparam a outros testes de fala sintetizados, disse Marc Slutzky, um neurologista da Northwestern que não estava envolvido no novo estudo, em um email. Slutzky recentemente trabalhou em um estudo similar que produziu palavras sintetizadas diretamente dos sinais do córtex cerebral, sem decodificar o movimento do trato vocal, e ele acredita que a qualidade da fala resultante foi semelhante, embora diferenças nas métricas de desempenho dificultem a comparação direta.

Um aspecto interessante do estudo da UCSF, no entanto, é que o decodificador pode generalizar alguns resultados entre os participantes, diz Slutzky. Um grande desafio para esse tipo de pesquisa é que o treinamento dos algoritmos do decodificador geralmente requer que os participantes falem, mas a tecnologia é voltada para pacientes que não podem mais falar. Ser capaz de generalizar parte do treinamento do algoritmo poderia permitir mais trabalho com pacientes paralisados.

Para enfrentar esse desafio, os pesquisadores também testaram o dispositivo com um participante que silenciosamente imitou as frases em vez de pronunciá-las em voz alta. Embora as sentenças resultantes não sejam tão precisas, os autores dizem que o fato de a síntese ser possível mesmo sem o discurso vocalizado tem implicações empolgantes.

"Foi realmente incrível descobrir que ainda poderíamos gerar um sinal de áudio a partir de um ato que não gerasse áudio", disse Josh Chartier, co-autor principal do estudante de pós-graduação em bioengenharia da UCSF, na coletiva de imprensa. .

Imagem do autor do estudo Gopala Anumanchipalli, PhD, segurando um exemplo de eletrodos intracranianos do tipo usado para registrar a atividade cerebral no estudo atual. (UCSF)

Imagem do autor do estudo Gopala Anumanchipalli, PhD, segurando um exemplo de eletrodos intracranianos do tipo usado para registrar a atividade cerebral no estudo atual. (UCSF) Outro objetivo para pesquisas futuras é buscar demonstrações em tempo real do decodificador, diz Anumanchipalli. O presente estudo foi concebido como uma prova de conceito - o decodificador foi desenvolvido separadamente do processo de coleta de dados, e a equipe não testou a velocidade em tempo real de traduzir a atividade cerebral para a fala sintetizada, embora esse seja o objetivo final da pesquisa. um dispositivo clínico.

Essa síntese em tempo real é algo que precisa ser melhorado para que tal dispositivo seja útil no futuro, diz Jaimie Henderson, um neurocirurgião de Stanford que não esteve envolvido no estudo. Ainda assim, ele diz que o método de dois estágios dos autores é uma nova abordagem empolgante, e o uso de tecnologia de aprendizagem profunda pode fornecer novos insights sobre como a fala realmente funciona.

"Para mim, apenas a ideia de começar a investigar a base subjacente de como a fala é produzida nas pessoas é muito emocionante", diz Henderson. “[Este estudo] começa a explorar uma das nossas capacidades mais humanas em um nível fundamental”.