Quando John Brennan, escolha do presidente Barack Obama para ser o próximo chefe da CIA, compareceu perante um comitê do Senado ontem, uma pergunta suplantou todas as outras em sua audiência de confirmação:

Como as decisões são tomadas para enviar drones assassinos após suspeitos de terrorismo?

O como e, por falar nisso, o porquê de ordenar drones específicos permanece em grande parte um mistério, mas pelo menos uma coisa está clara - as decisões estão sendo tomadas por humanos que, esperamos, lutam com o pensamento de enviar um míssil mortal. em um prédio ocupado.

Mas e se os humanos não estivessem envolvidos? E se um dia as decisões de vida ou morte fossem deixadas para as máquinas equipadas com um monte de dados, mas também uma sensação de certo e errado?

Dilema moral

Isso não é tão improvável. Isso não vai acontecer em breve, mas não há dúvida de que, à medida que as máquinas se tornam mais inteligentes e mais autônomas, uma parte essencial de sua transformação será a capacidade de aprender a moralidade.

Na verdade, isso pode não estar tão distante. Gary Marcus, escrevendo recentemente no The New Yorker, apresentou o cenário de um dos carros sem motorista do Google antes de ser forçado a tomar uma decisão em frações de segundo: “Seu carro está acelerando ao longo de uma ponte a 50 milhas por hora quando ônibus escolar levando 40 crianças inocentes atravessa o seu caminho. Seu carro deve desviar, possivelmente arriscando a vida de seu dono (você), a fim de salvar as crianças, ou continuar, colocando as 40 crianças em risco? Se a decisão tiver que ser tomada em milissegundos, o computador terá que fazer a chamada. ”

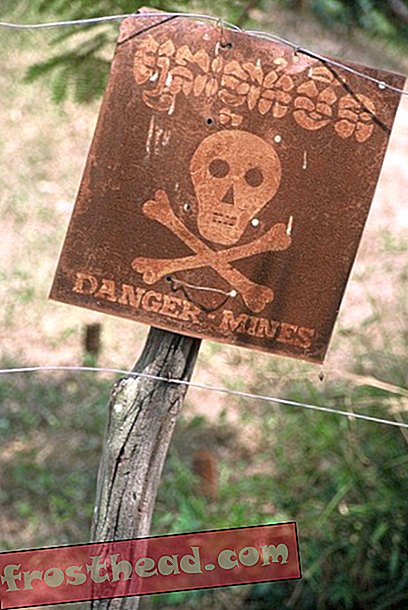

E as armas robóticas ou soldados? Um drone seria capaz de aprender a não atirar em uma casa se soubesse que civis inocentes também estavam dentro? As máquinas poderiam ser ensinadas a seguir as regras internacionais da guerra?

Ronald Arkin, professor de ciência da computação e especialista em robótica na Georgia Tech, certamente acha isso. Ele está desenvolvendo um software, chamado de "governador ético", que tornaria as máquinas capazes de decidir quando é apropriado disparar e quando não é.

Arkin reconhece que isso ainda pode demorar décadas, mas acredita que os robôs podem um dia ser fisicamente e eticamente superiores aos soldados humanos, não vulneráveis ao trauma emocional do combate ou ao desejo de vingança. Ele não visualiza um exército de robôs, mas um em que máquinas servem com humanos, fazendo trabalhos de alto risco cheios de decisões estressantes, como limpar prédios.

Cuidado com os robôs assassinos

Mas outros acham que é hora de esmagar esse tipo de pensamento antes que ele vá longe demais. No ano passado, a Human Rights Watch e a Human Rights Clinic de Harvard Law School publicaram um relatório “Perdendo a Humanidade: O Caso Contra Robôs Assassinos”, que, fiel ao seu título, pedia aos governos que proibissem todas as armas autônomas porque elas risco de morte ou ferimentos em civis durante conflitos armados ”.

Mais ou menos na mesma época, um grupo de professores da Universidade de Cambridge anunciou planos para lançar o que eles chamam de Centro para o Estudo do Risco Existencial. Quando for inaugurado ainda este ano, vai exigir pesquisas científicas sérias sobre o que pode acontecer se e quando as máquinas ficarem mais inteligentes que nós.

O perigo, diz Huw Price, um dos cofundadores do Centro, é que um dia poderíamos estar lidando com “máquinas que não são mal-intencionadas, mas máquinas cujos interesses não incluem nós”.

A arte do engano

Shades of Skynet, o sistema de inteligência artificial desonesto que gerou um cyborg Arnold Schwarzenegger nos filmes O Exterminador do Futuro . Talvez isso sempre seja coisa de ficção científica.

Mas considere outras pesquisas que Ronald Arkin está fazendo como parte de projetos financiados pelo Departamento de Defesa. Ele e seus colegas vêm estudando como os animais enganam uns aos outros, com o objetivo de ensinar aos robôs a arte do engano.

Por exemplo, eles têm trabalhado em robôs de programação para que eles possam, se necessário, fingir força como os animais costumam fazer. E eles têm procurado ensinar máquinas a imitar o comportamento de criaturas como o esquilo cinza oriental. Os esquilos escondem suas nozes de outros animais, e quando outros esquilos ou predadores aparecem, os esquilos cinzentos às vezes visitam lugares onde costumavam esconder nozes para jogar fora seus concorrentes. Robôs programados para seguir uma estratégia semelhante foram capazes de confundir e desacelerar os concorrentes.

É tudo do interesse, diz Arkin, de desenvolver máquinas que não sejam uma ameaça aos humanos, mas sim um ativo, particularmente no feio caos da guerra. A chave é começar a focar agora na definição de diretrizes para o comportamento adequado do robô.

"Quando você começa a abrir a Caixa de Pandora, o que deve ser feito com essa nova capacidade?", Ele disse em uma entrevista recente. "Acredito que há um potencial de mortes não combatentes serem diminuídas por esses robôs inteligentes, mas temos que ter muito cuidado com a forma como são usados e não apenas liberá-los no campo de batalha sem a devida preocupação".

Para acreditar no escritor nova-iorquino Gary Marcus, as máquinas eticamente avançadas oferecem um grande potencial além do campo de batalha.

O pensamento que mais me assombra é que a própria ética humana é apenas um trabalho em progresso. Ainda enfrentamos situações para as quais não temos códigos bem desenvolvidos (por exemplo, no caso de suicídio assistido) e não precisamos olhar muito para o passado para encontrar casos em que nossos próprios códigos eram dúbios ou piores (por exemplo, leis que escravidão e segregação permitidas).

O que realmente queremos são máquinas que possam dar um passo adiante, dotadas não apenas dos mais sólidos códigos de ética que nossos melhores filósofos contemporâneos podem conceber, mas também da possibilidade de as máquinas fazerem seu próprio progresso moral, ultrapassando nossas próprias limitações precoces. idéia do século XXI de moralidade ”.

Máquinas marcham

Aqui estão os desenvolvimentos mais recentes do robô:

- Hmmmm, ética e sorrateira: Pesquisadores na Austrália desenvolveram um robô que pode deslocar-se movendo-se apenas quando há ruído de fundo suficiente para encobrir seu som.

- O que é esse zumbido ?: Soldados britânicos no Afeganistão começaram a usar drones de vigilância que podem caber nas palmas de suas mãos. Chamado de Black Hornet Nano, o pequeno robô tem apenas quatro centímetros de comprimento, mas tem uma câmera espiã e pode voar por 30 minutos com carga total.

- Arranhando a superfície: a NASA está desenvolvendo um robô chamado RASSOR, que pesa apenas 100 libras, mas que poderá minerar minerais na Lua e em outros planetas. Ele pode se mover em terrenos acidentados e até mesmo em arvoredos, apoiando-se em seus braços.

- Ah, luxúria: E aqui está uma história do primeiro dia dos namorados. Cientistas da Universidade de Tóquio usaram uma traça macho para dirigir um robô. Na verdade, eles usaram seus movimentos de acasalamento para direcionar o dispositivo em direção a um objeto perfumado com feromônios de traça feminina.

Bônus por vídeo: Então você não tem certeza de que poderia operar um robô de 3 metros de altura? Sem problemas. Aqui está uma demo bacana que mostra o quão fácil pode ser. Um modelo feliz até mostra como operar o recurso “Smile Shot”. Você sorri, dispara BBs. Quão difícil é isso?

Mais de Smithsonian.com

Este robô é um pai melhor que seu pai

Robôs Conseguem o Toque Humano