Todos ouviram sobre os novos avanços na inteligência artificial e, especialmente, no aprendizado de máquina. Você também ouviu previsões utópicas ou apocalípticas sobre o que esses avanços significam. Eles foram levados a pressagiar a imortalidade ou o fim do mundo, e muito tem sido escrito sobre essas duas possibilidades. Mas as IAs mais sofisticadas ainda estão longe de serem capazes de resolver problemas que crianças humanas de quatro anos conseguem com facilidade. Apesar do nome impressionante, a inteligência artificial consiste em grande parte em técnicas para detectar padrões estatísticos em grandes conjuntos de dados. Há muito mais na aprendizagem humana.

Como podemos saber tanto sobre o mundo ao nosso redor? Aprendemos muito, mesmo quando somos crianças pequenas; crianças de quatro anos já conhecem plantas, animais e máquinas; desejos, crenças e emoções; até mesmo dinossauros e naves espaciais.

A ciência estendeu nosso conhecimento sobre o mundo ao inimaginavelmente grande e ao infinitesimalmente pequeno, ao limite do universo e ao começo do tempo. E usamos esse conhecimento para fazer novas classificações e previsões, imaginar novas possibilidades e fazer novas coisas acontecerem no mundo. Mas tudo o que alcança qualquer um de nós do mundo é uma corrente de fótons atingindo nossas retinas e distúrbios de ar em nossos tímpanos. Como aprendemos muito sobre o mundo quando a evidência que temos é tão limitada? E como fazemos tudo isso com os poucos quilos de gosma cinza que ficam atrás de nossos olhos?

A melhor resposta até agora é que nossos cérebros realizam cálculos sobre dados concretos, particulares e confusos que chegam aos nossos sentidos, e esses cálculos produzem representações precisas do mundo. As representações parecem ser estruturadas, abstratas e hierárquicas; elas incluem a percepção de objetos tridimensionais, as gramáticas subjacentes à linguagem e capacidades mentais como a “teoria da mente”, que nos permite entender o que as outras pessoas pensam. Essas representações nos permitem fazer uma ampla gama de novas previsões e imaginar muitas novas possibilidades de um modo humano distintamente criativo.

Esse tipo de aprendizado não é o único tipo de inteligência, mas é particularmente importante para os seres humanos. E é o tipo de inteligência que é uma especialidade de crianças pequenas. Embora as crianças sejam drasticamente ruins no planejamento e na tomada de decisões, elas são as melhores aprendizes do universo. Grande parte do processo de transformar dados em teorias acontece antes dos cinco anos.

Desde Aristóteles e Platão, houve duas maneiras básicas de abordar o problema de como sabemos o que sabemos e ainda são as principais abordagens no aprendizado de máquina. Aristóteles abordou o problema de baixo para cima: comece com os sentidos - o fluxo de fótons e vibrações de ar (ou os pixels ou amostras de som de uma imagem ou gravação digital) - e veja se você pode extrair padrões deles. Essa abordagem foi levada adiante por clássicos associacionistas como os filósofos David Hume e JS Mill e, mais tarde, por psicólogos comportamentais, como Pavlov e BF Skinner. Sob esse ponto de vista, a abstração e a estrutura hierárquica das representações é uma espécie de ilusão, ou pelo menos um epifenômeno. Todo o trabalho pode ser feito por meio de associação e detecção de padrões, especialmente se houver dados suficientes.

Mentes Possíveis: 25 Maneiras de Olhar para IA

John Brockman, o luminar do mundo da ciência, reúne 25 das mais importantes mentes científicas, pessoas que têm pensado sobre a inteligência artificial em campo para a maioria de suas carreiras, para um exame incomparável sobre mente, pensamento, inteligência e o que significa seja humano.

ComprarCom o tempo, houve uma oscilação entre essa abordagem de baixo para cima do mistério da aprendizagem e a alternativa de Platão, de cima para baixo. Talvez tenhamos conhecimento abstrato a partir de dados concretos, porque já sabemos muito e, especialmente, porque já temos uma série de conceitos abstratos básicos, graças à evolução. Como os cientistas, podemos usar esses conceitos para formular hipóteses sobre o mundo. Então, em vez de tentar extrair padrões dos dados brutos, podemos fazer previsões sobre como os dados devem ficar se essas hipóteses estiverem corretas. Juntamente com Platão, tais filósofos e psicólogos “racionalistas” como Descartes e Noam Chomsky adotaram essa abordagem.

Aqui está um exemplo diário que ilustra a diferença entre os dois métodos: resolver a praga do spam. Os dados consistem em uma lista longa e não classificada de mensagens na sua caixa de entrada. A realidade é que algumas dessas mensagens são genuínas e outras são spam. Como você pode usar os dados para discriminar entre eles?

Considere a técnica bottom-up primeiro. Você percebe que as mensagens de spam tendem a ter características particulares: uma longa lista de destinatários, origens na Nigéria, referências a prêmios de milhões de dólares ou Viagra. O problema é que mensagens perfeitamente úteis podem ter esses recursos também. Se você observasse exemplos suficientes de spam e e-mails não spam, poderá ver não apenas que os e-mails de spam tendem a ter esses recursos, mas que os recursos tendem a ser combinados de formas específicas (Nigéria mais um milhão de dólares). Na verdade, pode haver algumas correlações sutis de alto nível que discriminam as mensagens de spam das úteis - um padrão específico de erros ortográficos e endereços IP, digamos. Se você detectar esses padrões, poderá filtrar o spam.

As técnicas bottom-up de aprendizado de máquina fazem exatamente isso. O aluno recebe milhões de exemplos, cada um com um conjunto de recursos e cada um rotulado como spam (ou alguma outra categoria) ou não. O computador pode extrair o padrão de recursos que distingue os dois, mesmo que seja bastante sutil.

Como sobre a abordagem de cima para baixo? Eu recebo um email do editor do Journal of Clinical Biology . Refere-se a um dos meus trabalhos e diz que gostaria de publicar um artigo meu. Nenhuma Nigéria, nenhum Viagra, nenhum milhão de dólares; o email não possui nenhum dos recursos do spam. Mas usando o que eu já sei e pensando de forma abstrata sobre o processo que produz spam, posso descobrir que esse e-mail é suspeito:

1. Eu sei que os spammers tentam extrair dinheiro das pessoas apelando para a cobiça humana.

2. Também sei que revistas legítimas de “acesso aberto” começaram a cobrir seus custos cobrando autores em vez de assinantes, e que eu não pratico nada como biologia clínica.

Coloque tudo isso junto e eu posso produzir uma boa nova hipótese sobre de onde veio esse email. Ele é projetado para levar os acadêmicos a pagar para “publicar” um artigo em um diário falso. O e-mail era resultado do mesmo processo duvidoso que os outros e-mails de spam, mesmo que não se parecesse com eles. Eu posso tirar essa conclusão de apenas um exemplo, e posso continuar a testar minha hipótese, além de qualquer coisa no próprio e-mail, pesquisando o "editor".

Em termos de computação, comecei com um "modelo generativo" que inclui conceitos abstratos como ganância e fraude e descreve o processo que produz golpes de e-mail. Isso me permite reconhecer o spam de e-mail nigeriano clássico, mas também me permite imaginar muitos tipos diferentes de spam possível. Quando recebo o e-mail da revista, posso retroceder: "Esse parece ser o tipo de correspondência que sai de um processo gerador de spam".

A nova empolgação com a IA ocorre porque os pesquisadores da IA produziram recentemente versões poderosas e eficazes de ambos os métodos de aprendizado. Mas não há nada de profundamente novo nos métodos em si.

Aprendizagem profunda de baixo para cima

Na década de 1980, os cientistas da computação criaram uma maneira engenhosa de fazer os computadores detectarem padrões em dados: arquitetura conexionista ou de rede neural (a parte "neural" era, e ainda é, metafórica). A abordagem caiu na crise na década de 1990, mas foi recentemente revivida com poderosos métodos de "aprendizagem profunda", como o DeepMind, do Google.

Por exemplo, você pode dar a um programa de aprendizagem profunda um monte de imagens da Internet rotuladas como "gato", outras rotuladas como "casa" e assim por diante. O programa pode detectar os padrões que diferenciam os dois conjuntos de imagens e usar essas informações para rotular as novas imagens corretamente. Alguns tipos de aprendizado de máquina, chamados de aprendizado não supervisionado, podem detectar padrões em dados sem rótulos; eles simplesmente procuram por conjuntos de recursos - o que os cientistas chamam de análise fatorial. Nas máquinas de aprendizagem profunda, esses processos são repetidos em diferentes níveis. Alguns programas podem até descobrir recursos relevantes dos dados brutos de pixels ou sons; o computador pode começar detectando os padrões na imagem não processada que correspondem a arestas e linhas e, em seguida, encontrar os padrões nesses padrões que correspondem aos rostos, e assim por diante.

Outra técnica de baixo para cima, com uma longa história, é o aprendizado por reforço. Na década de 1950, BF Skinner, baseando-se no trabalho de John Watson, notoriamente programou pombos para realizar ações elaboradas - até mesmo guiando mísseis lançados pelo ar para seus alvos (um eco perturbador da IA recente) dando-lhes uma programação específica de recompensas e punições. . A ideia essencial era que as ações recompensadas seriam repetidas e as que fossem punidas, até que o comportamento desejado fosse alcançado. Mesmo nos dias de Skinner, esse processo simples, repetido várias vezes, pode levar a um comportamento complexo. Os computadores são projetados para executar operações simples repetidamente em uma escala que supera a imaginação humana, e os sistemas computacionais podem aprender habilidades extraordinariamente complexas dessa maneira.

Por exemplo, os pesquisadores da DeepMind do Google usaram uma combinação de aprendizagem profunda e aprendizado por reforço para ensinar um computador a jogar videogames da Atari. O computador não sabia nada sobre como os jogos funcionavam. Começou por agir aleatoriamente e obteve informações apenas sobre o que a tela parecia em cada momento e quão bem tinha marcado. A aprendizagem profunda ajudou a interpretar os recursos na tela, e o aprendizado por reforço recompensou o sistema em busca de pontuações mais altas. O computador ficou muito bom em jogar vários dos jogos, mas também bombardeou completamente outros que eram tão fáceis para os humanos dominarem.

Uma combinação semelhante de aprendizado profundo e aprendizagem de reforço possibilitou o sucesso do AlphaZero, um programa que conseguiu vencer jogadores humanos tanto no xadrez quanto no Go, equipado apenas com um conhecimento básico das regras do jogo e algumas capacidades de planejamento. O AlphaZero tem outro recurso interessante: ele funciona jogando centenas de milhões de jogos contra si mesmo. Ao fazê-lo, retira erros que levam a perdas e repete e elabora estratégias que levaram a vitórias. Tais sistemas, e outros envolvendo técnicas chamadas de redes adversárias geradoras, geram dados e também observam dados.

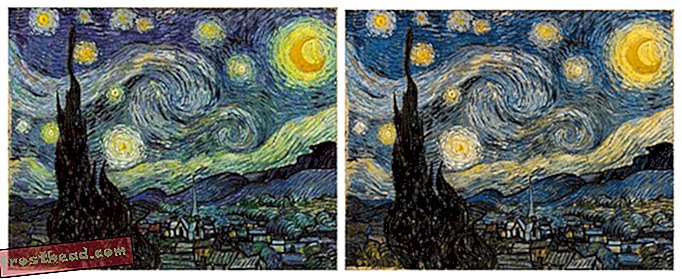

Quando você tem o poder computacional para aplicar essas técnicas a conjuntos de dados muito grandes ou milhões de mensagens de e-mail, imagens do Instagram ou gravações de voz, você pode resolver problemas que antes pareciam muito difíceis. Essa é a fonte de grande parte da empolgação na ciência da computação. Mas vale a pena lembrar que esses problemas - como reconhecer que uma imagem é um gato ou uma palavra falada é Siri - são triviais para uma criança humana. Uma das descobertas mais interessantes da ciência da computação é que os problemas que são fáceis para nós (como identificar gatos) são difíceis para os computadores - muito mais difícil do que jogar xadrez ou ir. Os computadores precisam de milhões de exemplos para categorizar objetos que podemos categorizar com apenas alguns. Esses sistemas bottom-up podem generalizar para novos exemplos; eles podem rotular uma nova imagem como um gato com bastante precisão. Mas eles o fazem de maneiras bem diferentes de como os humanos generalizam. Algumas imagens quase idênticas a uma imagem de gato não serão identificadas por nós como gatos. Outros que se parecem com um borrão aleatório serão.

Modelos bayesianos de cima para baixo

A abordagem de cima para baixo desempenhou um grande papel no início da IA e, nos anos 2000, também experimentou um renascimento, na forma de modelos generativos probabilísticos ou bayesianos.

As primeiras tentativas de usar essa abordagem enfrentaram dois tipos de problemas. Em primeiro lugar, a maioria dos padrões de evidência pode, em princípio, ser explicada por muitas hipóteses diferentes: É possível que a mensagem de e-mail do meu diário seja genuína, apenas não parece provável. Em segundo lugar, onde os conceitos que os modelos gerativos usam vêm em primeiro lugar? Platão e Chomsky disseram que você nasceu com eles. Mas como podemos explicar como aprendemos os conceitos mais recentes da ciência? Ou até mesmo crianças pequenas entendem sobre dinossauros e foguetes?

Modelos bayesianos combinam modelos generativos e testes de hipóteses com a teoria da probabilidade, e eles abordam esses dois problemas. Um modelo Bayesiano permite calcular quão provável é uma hipótese específica, dados os dados. E fazendo pequenos ajustes sistemáticos nos modelos que já temos e testando-os em relação aos dados, às vezes podemos criar novos conceitos e modelos a partir dos antigos. Mas essas vantagens são compensadas por outros problemas. As técnicas bayesianas podem ajudá-lo a escolher qual das duas hipóteses é mais provável, mas quase sempre há um número enorme de hipóteses possíveis, e nenhum sistema pode considerá-las com eficiência. Como você decide quais hipóteses valem a pena testar em primeiro lugar?

Brenden Lake, da NYU, e seus colegas usaram esses métodos top-down para resolver outro problema que é fácil para as pessoas, mas extremamente difícil para os computadores: reconhecer caracteres manuscritos desconhecidos. Olhe para um personagem em um pergaminho japonês. Mesmo que você nunca tenha visto isso antes, você provavelmente pode dizer se é semelhante ou diferente de um personagem em outro pergaminho japonês. Você provavelmente pode desenhá-lo e até criar um personagem japonês falso baseado no que vê - um que seja bem diferente de um personagem coreano ou russo.

O método ascendente para reconhecer caracteres manuscritos é dar ao computador milhares de exemplos de cada um deles e deixá-lo extrair as características salientes. Em vez disso, Lake et al. deu ao programa um modelo geral de como você desenha um personagem: Um traço vai para a direita ou para a esquerda; depois de terminar um, você começa outro; e assim por diante. Quando o programa via um caractere em particular, ele poderia inferir a sequência de traços que provavelmente o levaram a ele - assim como eu deduzi que o processo de spam levou ao meu e-mail duvidoso. Então, ele poderia julgar se um novo personagem provavelmente resultaria dessa sequência ou de um diferente, e poderia produzir um conjunto semelhante de traços em si. O programa funcionou muito melhor do que um programa de aprendizagem profunda aplicado exatamente aos mesmos dados, e espelhava de perto o desempenho dos seres humanos.

Essas duas abordagens para aprendizado de máquina têm pontos fortes e fracos complementares. Na abordagem bottom-up, o programa não precisa de muito conhecimento para começar, mas precisa de uma grande quantidade de dados e pode ser generalizado apenas de maneira limitada. Na abordagem de cima para baixo, o programa pode aprender apenas com alguns exemplos e fazer generalizações muito mais amplas e variadas, mas você precisa construir muito mais nele para começar. Diversos pesquisadores estão atualmente tentando combinar as duas abordagens, usando o aprendizado profundo para implementar a inferência bayesiana.

O sucesso recente da IA é em parte o resultado de extensões dessas idéias antigas. Mas tem mais a ver com o fato de que, graças à Internet, temos muito mais dados e, graças à Lei de Moore, temos muito mais poder computacional para aplicar a esses dados. Além disso, um fato não apreciado é que os dados que temos já foram classificados e processados por seres humanos. As fotos de gatos publicadas na Web são imagens canônicas de gatos - imagens que os humanos já escolheram como “boas” fotos. O Google Tradutor funciona porque tira proveito de milhões de traduções humanas e as generaliza para um novo texto, em vez de compreender genuinamente as próprias frases.

Mas a coisa realmente notável sobre as crianças humanas é que elas de alguma forma combinam as melhores características de cada abordagem e então vão além delas. Nos últimos quinze anos, os desenvolvimentistas têm explorado a forma como as crianças aprendem a estrutura a partir dos dados. Crianças de quatro anos podem aprender tirando apenas um ou dois exemplos de dados, como faz um sistema top-down, e generalizando para conceitos muito diferentes. Mas eles também podem aprender novos conceitos e modelos a partir dos dados em si, como faz um sistema de baixo para cima.

Por exemplo, em nosso laboratório, damos às crianças um “detector de blicket” - uma nova máquina para descobrir, uma que nunca viram antes. É uma caixa que se ilumina e toca música quando você coloca certos objetos nela, mas não em outros. Damos às crianças apenas um ou dois exemplos de como a máquina funciona, mostrando-lhes que, digamos, dois blocos vermelhos fazem isso funcionar, enquanto uma combinação verde e amarela não funciona. Mesmo jovens de dezoito meses imediatamente descobrem o princípio geral de que os dois objetos têm que ser os mesmos para fazê-lo, e eles generalizam esse princípio para novos exemplos: por exemplo, eles escolherão dois objetos que têm a mesma forma para fazer. o trabalho da máquina. Em outros experimentos, mostramos que as crianças podem até descobrir que alguma propriedade invisível invisível faz a máquina funcionar ou que a máquina funciona com algum princípio lógico abstrato.

Você pode mostrar isso também no aprendizado diário das crianças. As crianças pequenas aprendem rapidamente as teorias intuitivas abstratas da biologia, da física e da psicologia da mesma maneira que os cientistas adultos, mesmo com relativamente poucos dados.

As notáveis realizações de aprendizado de máquina dos sistemas recentes de IA, de baixo para cima e de cima para baixo, ocorrem em um espaço estreito e bem definido de hipóteses e conceitos - um conjunto preciso de peças e movimentos, um conjunto predeterminado de imagens. . Em contraste, crianças e cientistas às vezes mudam seus conceitos de maneiras radicais, realizando mudanças de paradigma em vez de simplesmente ajustar os conceitos que já possuem.

As crianças de quatro anos de idade podem reconhecer imediatamente os gatos e entender as palavras, mas também podem fazer novas e surpreendentes inferências que vão muito além de sua experiência. Meu próprio neto explicou recentemente, por exemplo, que se um adulto quiser se tornar uma criança novamente, ele deve tentar não comer nenhum vegetal saudável, uma vez que vegetais saudáveis fazem a criança se tornar adulta. Esse tipo de hipótese, plausível que nenhum adulto jamais consideraria, é característico de crianças pequenas. De fato, meus colegas e eu mostramos sistematicamente que os pré-escolares são melhores em apresentar hipóteses improváveis do que crianças mais velhas e adultos. Não temos quase nenhuma ideia de como esse tipo de aprendizado criativo e inovação é possível.

Observar o que as crianças fazem, no entanto, pode dar aos programadores dicas úteis sobre as instruções para o aprendizado de computadores. Duas características da aprendizagem das crianças são especialmente impressionantes. As crianças são aprendizes ativos; eles não apenas absorvem passivamente dados como os AIs. Assim como os cientistas experimentam, as crianças são intrinsecamente motivadas a extrair informações do mundo ao seu redor, através de seu jogo e exploração sem fim. Estudos recentes mostram que essa exploração é mais sistemática do que parece e está bem adaptada para encontrar evidências convincentes para apoiar a formação de hipóteses e a escolha de teorias. Construir a curiosidade em máquinas e permitir que elas interajam ativamente com o mundo pode ser um caminho para uma aprendizagem mais realista e abrangente.

Em segundo lugar, as crianças, diferentemente das AIs existentes, são aprendizes sociais e culturais. Os humanos não aprendem isoladamente, mas aproveitam a sabedoria acumulada das gerações passadas. Estudos recentes mostram que até os pré-escolares aprendem através da imitação e ouvindo o testemunho dos outros. Mas eles não simplesmente obedecem passivamente a seus professores. Em vez disso, eles captam informações de outras pessoas de maneira notavelmente sutil e sensível, fazendo inferências complexas sobre de onde vem a informação e como ela é confiável e integrando sistematicamente suas próprias experiências com o que estão ouvindo.

"Inteligência artificial" e "aprendizado de máquina" soam assustadores. E de certa forma eles são. Estes sistemas estão sendo usados para controlar armas, por exemplo, e nós deveríamos estar realmente assustados com isso. Ainda assim, a estupidez natural pode causar muito mais estragos do que a inteligência artificial; nós, seres humanos, precisaremos ser muito mais inteligentes do que estivemos no passado para regular adequadamente as novas tecnologias. Mas não há muita base para a visão apocalíptica ou utópica das IAs que substituem os humanos. Até que resolvamos o paradoxo básico da aprendizagem, as melhores inteligências artificiais serão incapazes de competir com a média humana de quatro anos de idade.

A partir da próxima coleção POSSÍVEL MENTES: 25 maneiras de olhar para AI, editado por John Brockman. Publicado por acordo com a Penguin Press, um membro da Penguin Random House LLC. Copyright © 2019 John Brockman.