Todos os dias surgem inúmeras manchetes de inúmeras fontes ao redor do globo, tanto alertando para conseqüências terríveis quanto prometendo futuros utópicos - tudo graças à inteligência artificial. A IA “está transformando o local de trabalho”, escreve o Wall Street Journal, enquanto a revista Fortune nos diz que estamos diante de uma “revolução da IA” que “mudará nossas vidas”. Mas não entendemos o que interagir com a IA - ou como deveria ser.

Acontece, no entanto, que já temos um conceito que podemos usar quando pensamos em IA: é como pensamos sobre os animais. Como um ex-treinador de animais (embora brevemente) que agora estuda como as pessoas usam AI, eu sei que animais e treinamento animal podem nos ensinar muito sobre como devemos pensar, abordar e interagir com a inteligência artificial, tanto agora quanto no mundo. futuro.

Usar analogias com animais pode ajudar pessoas comuns a entender muitos dos aspectos complexos da inteligência artificial. Ele também pode nos ajudar a pensar sobre a melhor maneira de ensinar a esses novos sistemas habilidades e, talvez mais importante, como podemos conceber adequadamente suas limitações, mesmo quando celebramos as novas possibilidades da IA.

Olhando para as restrições

Como a especialista em IA Maggie Boden explica, “a inteligência artificial busca fazer os computadores fazerem o tipo de coisas que as mentes podem fazer”. Pesquisadores de inteligência artificial estão trabalhando no ensino de computadores para raciocinar, perceber, planejar, mover e fazer associações. A IA pode ver padrões em grandes conjuntos de dados, prever a probabilidade de ocorrência de um evento, planejar uma rota, gerenciar a agenda de reuniões de uma pessoa e até mesmo fazer cenários de jogos de guerra.

Muitas dessas capacidades não são, em si, surpreendentes: é claro que um robô pode rolar em torno de um espaço e não colidir com nada. Mas, de alguma forma, a IA parece mais mágica quando o computador começa a juntar essas habilidades para realizar tarefas.

Tomemos, por exemplo, carros autônomos. As origens do carro sem motorista estão em um projeto da Agência de Projeto de Pesquisa Avançada de Defesa da década de 80, chamado Veículo Terrestre Autônomo. Os objetivos do projeto eram incentivar a pesquisa em visão computacional, percepção, planejamento e controle robótico. Em 2004, o esforço ALV se tornou o primeiro Grande Desafio para carros autônomos. Agora, mais de 30 anos após o início do esforço, estamos à beira de carros autônomos ou autônomos no mercado civil. Nos primeiros anos, poucas pessoas achavam que tal feito era impossível: os computadores não podiam dirigir!

No entanto, como vimos, eles podem. As capacidades dos carros autônomos são relativamente fáceis de entender. Mas nos esforçamos para compreender suas limitações. Depois do acidente fatal de Tesla em 2015, onde a função de piloto automático do carro não conseguiu detectar um trator-reboque cruzando a pista, poucos ainda parecem entender a gravidade de quão limitado o piloto automático de Tesla realmente é. Embora a empresa e seu software tenham sido inocentados pela Administração Nacional de Segurança no Trânsito nas Estradas, ainda não está claro se os clientes realmente entendem o que o carro pode ou não fazer.

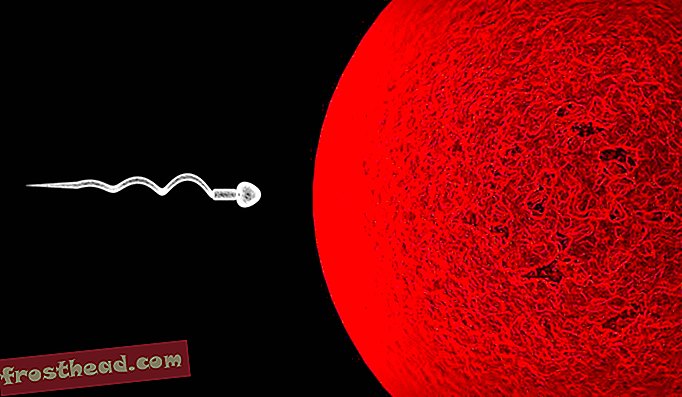

E se os donos de Tesla soubessem que não estavam dirigindo uma versão “beta” de um piloto automático, mas sim um carro semi-autônomo com a equivalência mental de um verme? A chamada “inteligência”, que fornece “capacidade total de auto-direção”, é na verdade um computador gigante que é muito bom em detectar objetos e evitá-los, reconhecendo itens em imagens e planejamento limitado. Isso pode mudar as perspectivas dos proprietários sobre o quanto o carro poderia realmente fazer sem a entrada ou a supervisão humana.

O que é isso?

Tecnólogos freqüentemente tentam explicar a IA em termos de como ela é construída. Tomemos, por exemplo, os avanços feitos no aprendizado profundo. Essa é uma técnica que usa redes com várias camadas para aprender como executar uma tarefa. As redes precisam processar grandes quantidades de informação. Mas por causa do volume de dados que eles exigem, da complexidade das associações e dos algoritmos nas redes, muitas vezes não é claro para os humanos como eles aprendem o que fazem. Esses sistemas podem se tornar muito bons em uma tarefa específica, mas não os entendemos realmente.

Em vez de pensar sobre a IA como algo sobre-humano ou alienígena, é mais fácil fazer uma analogia com os animais, os não-humanos inteligentes que temos experiência em treinamento.

Por exemplo, se eu usasse o aprendizado de reforço para treinar um cachorro para sentar, eu elogiaria o cão e daria a ele as guloseimas quando ele sentasse sob comando. Com o tempo, ele aprenderia a associar o comando ao comportamento com o deleite.

Treinar um sistema de IA pode ser o mesmo. No reforço da aprendizagem profunda, os designers humanos criam um sistema, imaginam o que querem aprender, dão informações, observam suas ações e dão feedback (como elogios) quando vêem o que querem. Em essência, podemos tratar o sistema da IA como tratamos os animais que estamos treinando.

A analogia funciona em um nível mais profundo também. Não estou esperando que o cão sentado entenda conceitos complexos como "amor" ou "bom". Estou esperando que ele aprenda um comportamento. Assim como podemos fazer os cães se sentarem, ficarem e rolarem, podemos obter sistemas de IA para mover carros pelas estradas públicas. Mas é demais esperar que o carro “resolva” os problemas éticos que podem surgir na condução de emergências.

Ajudando também os pesquisadores

Pensar na IA como um animal treinável não é útil apenas para explicar isso ao público em geral. Também é útil para os pesquisadores e engenheiros que estão construindo a tecnologia. Se um acadêmico de IA está tentando ensinar a um sistema uma nova habilidade, pensar no processo a partir da perspectiva de um treinador de animais poderia ajudar a identificar possíveis problemas ou complicações.

Por exemplo, se eu tentar treinar meu cachorro para sentar, e toda vez que eu disser "sentar" a campainha do forno, o meu cachorro começará a associar-se não apenas com o meu comando, mas também com o som da campainha. campainha do forno. Em essência, a campainha se torna outro sinal que diz ao cão para se sentar, o que é chamado de “reforço acidental”. Se procurarmos reforços acidentais ou sinais em sistemas de IA que não estão funcionando corretamente, então saberemos melhor não só o que está acontecendo. errado, mas também que reciclagem específica será mais eficaz.

Isso requer que entendamos quais mensagens estamos dando durante o treinamento de IA, bem como o que a IA pode estar observando no ambiente ao redor. A campainha do forno é um exemplo simples; no mundo real, será muito mais complicado.

Antes de dar as boas-vindas aos nossos senhores da IA e entregar nossas vidas e empregos aos robôs, devemos fazer uma pausa e pensar sobre o tipo de inteligência que estamos criando. Eles serão muito bons em realizar ações ou tarefas específicas, mas não podem entender conceitos e não sabem nada. Então, quando você está pensando em gastar milhares de dólares em um novo carro da Tesla, lembre-se de que sua função de piloto automático é apenas um verme muito rápido e sexy. Você realmente quer dar controle sobre sua vida e a vida de seus entes queridos para um verme? Provavelmente não, por isso mantenha as mãos no volante e não adormeça.

Este artigo foi originalmente publicado no The Conversation.

Heather Roff, pesquisadora sênior do Departamento de Política e Relações Internacionais da Universidade de Oxford; Cientista de pesquisa, Global Security Initiative, Universidade Estadual do Arizona