O rosto humano é alimentado, dependendo de como você os conta, por entre 23 e 43 músculos, muitos dos quais se ligam à pele, não servindo nenhuma função óbvia para a sobrevivência. Um alienígena examinando um espécime humano isoladamente não saberia o que fazer com eles. Puxando a testa, sobrancelhas, lábios e bochechas, os músculos transmitem uma riqueza de informações sobre nosso estado emocional, nível de interesse e agilidade. É um meio de comunicação incrivelmente eficiente - quase instantâneo, geralmente preciso, que transcende a maioria das barreiras linguísticas e culturais. Mas às vezes os dados são perdidos, ignorados ou mal interpretados. Se um madeireiro sorri na floresta sem ninguém por perto para vê-lo, ele estava realmente feliz?

Desta história

[×] FECHAR

Tão longos emoticons. O cientista está desenvolvendo tecnologia que pode detectar e ler nossas expressões

Vídeo: Smithsonian Ingenuity Awards 2015: Rana el Kaliouby

Leituras Relacionadas

Inteligência Emocional: Por que pode importar mais do que o QI?

ComprarRana el Kaliouby odeia ver essa informação desperdiçada. Encontrando-me com El Kaliouby em seu pequeno escritório em Waltham, Massachusetts, vejo-a contrair seu músculo zigomático maior, levantando os cantos de sua boca e seu orbicular dos olhos, enrugando os cantos externos de seus olhos. Ela está sorrindo, e deduzo que ela está me dando as boas-vindas, antes mesmo de receber a palavra “olá”. Mas muitas trocas sociais hoje ocorrem sem a interação face a face em tempo real. É aí que entram El Kaliouby e sua companhia.

El Kaliouby, de 37 anos, sorri frequentemente. Ela tem um rosto redondo, agradável e expressivo, e um jeito solícito, contrariando sua posição de co-fundadora de uma start-up de tecnologia em rápido crescimento - uma anti-Bezos, uma não-Zuckerberg. Sua empresa, a Affectiva, que ela fundou em 2009 com uma então colega no Laboratório de Mídia do MIT, Rosalind Picard, ocupa uma posição na vanguarda da tecnologia para usar computadores para detectar e interpretar expressões faciais humanas. Este campo, conhecido como "computação afetiva", procura fechar a lacuna de comunicação entre seres humanos e máquinas, adicionando um novo modo de interação, incluindo a linguagem não-verbal de sorrisos, sorrisos e sobrancelhas levantadas. "A premissa do que fazemos é que as emoções são importantes", diz el Kaliouby. “As emoções não atrapalham nosso pensamento racional, mas o orientam e informam. Mas eles estão faltando em nossa experiência digital. Seu smartphone sabe quem você é e onde você está, mas não sabe como se sente. Nosso objetivo é consertar isso.

Por que seu smartphone precisa saber como você se sente? El Kaliouby tem uma série de respostas, todas baseadas na integração aparentemente ilimitada de computadores nas rotinas de nossas vidas diárias. Ela visualiza “tecnologia para controlar iluminação, temperatura e música em nossas casas em resposta a nossos estados de espírito”, ou aplicativos que podem adaptar o conteúdo de um filme com base em suas reações subconscientes enquanto assiste. Ela imagina programas que podem monitorar sua expressão enquanto você dirige e avisa sobre desatenção, sonolência ou raiva. Ela sorri com a menção de sua idéia favorita - "uma geladeira que pode sentir quando você está estressada e trava o sorvete."

Em particular, ela acha que o Affectiva, e a tecnologia que está ajudando a introduzir no mainstream, será uma benção para a saúde. Um pesquisador testando um novo medicamento, ou um terapeuta tratando um paciente, obtém feedback apenas em intervalos, sujeito a todos os problemas de autorrelato - o desejo inconsciente de agradar ao médico, por exemplo, ou a lembrança seletiva que favorece as memórias mais recentes. . El Kaliouby visualiza um programa rodando no fundo do laptop ou telefone do sujeito que poderia compilar um registro de momento a momento de seu humor ao longo de um período de tempo (um dia, um mês) e correlacioná-lo com o tempo ou qualquer outra coisa que o seu dispositivo possa medir ou rastrear. “Não teria que fazer parte de um programa de tratamento”, ela reflete. “Você pode ter isso no seu telefone e diz, toda vez que 'X' liga, você tem uma expressão negativa, e isso diz algo que você pode não saber.”

Assine a revista Smithsonian agora por apenas $ 12

Esta história é uma seleção da edição de dezembro da revista Smithsonian.

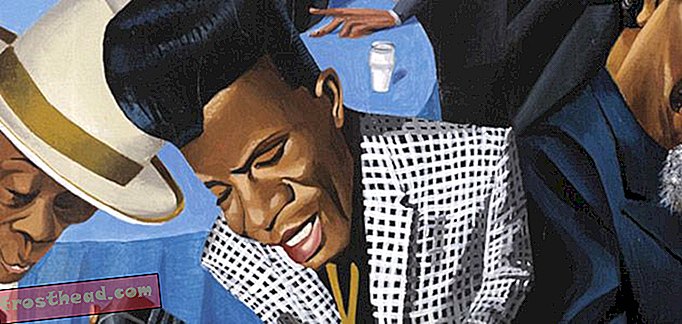

ComprarEl Kaliouby promove a computação afetiva como o próximo passo lógico na progressão do teclado para o mouse, para o touchscreen e para o reconhecimento de voz. Na primavera, a Affectiva lançou seu primeiro kit de desenvolvimento de software comercial, que os desenvolvedores, interessados nos estados emocionais em tempo real dos usuários, podem incorporar em seus próprios programas - tocadores de música ou aplicativos de jogos ou namoro, por exemplo. E neste outono, a Affectiva lançou o Emotion As a Service, um programa baseado na nuvem para o qual os clientes podem enviar vídeos para análise. Quem pode usar isso? Um candidato prestes a ser entrevistado para um emprego, que está preocupado em parecer ansioso ou entediado ou até mesmo sorrir demais. Ou uma companhia aérea contratando comissários de bordo, com centenas de aplicativos de vídeo para vasculhar em busca daqueles que conseguem dar um sorriso convincente enquanto se despedem dos passageiros. (Um sorriso genuíno, que envolve uma contração dos músculos nos cantos dos olhos, é chamado de "Duchenne" sorriso, nomeado para o anatomista do século 19; o seu oposto, um sorriso forçado que usa apenas a boca, às vezes é chamado de "Pan Am" sorriso.

E, é claro, todos os dispositivos que executam esse software estão conectados à Internet, de modo que as informações coletadas são instantaneamente agregadas, peneiradas e conectadas em rede na forma como os aplicativos de mídia social identificam tópicos ou personalidades populares. Compilado, talvez, em algo como um Índice de Humor Afetivo, uma leitura numérica sobre a felicidade nacional bruta, ou dividida em regiões onde sorrisos ou carrancas estão tendendo atualmente.

O programa básico da Affectiva analisa o rosto 20 vezes por segundo para 46 expressões localizadas de felicidade, tristeza, surpresa, medo, raiva, nojo e desprezo, além de interesse e confusão. (Naomi Shavin / Smithsonian)

O programa básico da Affectiva analisa o rosto 20 vezes por segundo para 46 expressões localizadas de felicidade, tristeza, surpresa, medo, raiva, nojo e desprezo, além de interesse e confusão. (Naomi Shavin / Smithsonian) Até o momento, os principais clientes da Affectiva são empresas de publicidade, marketing e mídia. Seu software automatiza o processo de executar um grupo focal, o complicado ritual de reunir uma dúzia de pessoas em uma sala para opinar sobre um novo produto, série de TV ou campanha publicitária; registra reações diretamente, sem que um participante tenha que girar um mostrador ou responder a um questionário em resposta a uma apresentação. Além disso, o software expande o grupo de foco em potencial para o mundo inteiro, ou pelo menos a fração substancial dele que tem um computador ou dispositivo móvel habilitado para webcam.

O feedback do olho implacável e que tudo indica da Affectiva ajudou a moldar uma sitcom de TV em rede, condenando dois personagens ao esquecimento pelo pecado de não fazer os espectadores sorrirem. (El Kaliouby não identificará o programa nem os personagens.) Seu software foi usado para construir um “sampler de sorriso”, uma máquina que distribuía barras de chocolate para compradores que sorriam para sua câmera. Com mais pesquisas, provavelmente poderia ser útil para a vigilância de multidões em aeroportos, ou para identificar potenciais ladrões de lojas, ou como detector de mentiras.

Mas Kaliouby resistiu a essas aplicações sub-reptícias, por mais lucrativas que fossem. Ela acha que a computação afetiva vai mudar o mundo, inclusive, mas de forma alguma limitada a, a venda de barras de chocolate. “O espírito de nossa empresa”, diz ela, “é usar essa tecnologia para melhorar a vida das pessoas e ajudá-las a se comunicar melhor, não apenas para ajudar os anunciantes a vender mais produtos”.

**********

Ao contrário de muitos empreendedores de tecnologia, ficar rico não estava na agenda original de Kaliouby. Nascida no Cairo para pais egípcios que trabalham com tecnologia, ela estudou ciências da computação na Universidade Americana no Cairo, onde se formou em 1998, na época em que computadores estavam se tornando poderosos o suficiente para os pesquisadores pensarem em dotá-los com o que em termos humanos é chamado inteligência emocional.

Ela continuou estudando ciência da computação na Universidade de Cambridge, chegando logo após os ataques à América do 11 de setembro de 2001. Seus pais pensaram que ela se arriscaria a ser presa, assediada ou pior por causa de sua herança. Mas embora ela usasse uma capa de cabeça muçulmana até dois anos atrás, nem em Cambridge, Inglaterra, nem em Cambridge, Massachusetts, para onde se mudou em 2006, para se juntar ao MIT Media Lab, ela nunca se preocupou com sua religião ou aparência. . "Eu acho que é porque eu sorrio muito", diz ela, sorrindo.

O anatomista francês Duchenne publicou estudos de referência sobre expressões faciais humanas. Imagens de Bridgeman

O anatomista francês Duchenne publicou estudos de referência sobre expressões faciais humanas. Imagens de Bridgeman Enquanto em Cambridge, ela se interessou pelo problema do autismo, especificamente a dificuldade que as crianças autistas têm em ler expressões faciais. Ela propôs a construção de um “aparelho auditivo emocional” que pudesse ser usado para ler rostos e sugerir comportamentos adequados ao usuário. Recusada no início por uma concessão da National Science Foundation, alegando que o projeto era muito difícil, ela e seus colegas construíram um protótipo, consistindo de um par de óculos equipado com uma pequena câmera, luzes piscando e um fone de ouvido, não muito diferente de uma versão inicial do Google Glass. Um segundo pedido de subsídio foi bem-sucedido e, depois que ela se mudou para o MIT, ela e sua equipe trabalharam nos próximos três anos para aperfeiçoá-lo e testá-lo em uma escola em Rhode Island. El Kaliouby descreve-o como “um projeto de pesquisa e um projeto de sucesso” - as crianças autistas que o usaram tinham experiências esmagadoramente positivas - mas em 2008, quando a bolsa acabou, ela enfrentou um momento de avaliação. O interesse comercial na computação afetiva estava crescendo, e ela queria vê-lo expandir e florescer; colocar seus esforços no desenvolvimento dos óculos iria limitá-lo a uma pequena fatia de seus usos potenciais. Então, junto com Picard, ela desmembrou o Affectiva, enquanto esperava que outra empresa pegasse o aparelho auditivo emocional e o colocasse no mercado.

Quando a Affectiva foi formada, os poucos “membros da equipe” que compunham a empresa escolheram um valor que queriam incorporar, como “aprendizagem” ou “responsabilidade social” ou “diversão”. Ela, como diretora de estratégia e ciência, foi “paixão”. A empresa de 20 pessoas é administrada como uma quase democracia, com reuniões semestrais nas quais os funcionários votam nas prioridades a serem seguidas nos próximos seis meses. Seu escritório tem uma lousa coberta com desenhos da jovem filha de um de seus colegas; ela tem um filho de 6 anos, Adam, e uma filha de 12 anos, Jana, que mora com ela nos subúrbios de Boston (o pai deles mora no Egito). Sua maneira é suave e atenciosa; uma hora em uma reunião matinal, ela se oferece para pedir um sanduíche para uma visita, mesmo que ela mesma esteja pulando o almoço. "É o Ramadã para mim", ela diz, sorrindo, "mas não é o Ramadã para você".

Ela acomoda os visitantes em uma mesa, de frente para um monitor e uma webcam; o software localiza o rosto do visitante e desenha uma caixa ao redor dele na tela. Ele identifica um conjunto de pontos para rastrear: os cantos dos olhos e da boca, a ponta do nariz e assim por diante. Vinte vezes por segundo, o software procura por “unidades de ação”, o jogo de músculos frequentemente fugaz na face. Existem 46 destes, de acordo com o sistema padrão de classificação, o Sistema de Codificação de Ação Facial (FACS). Eles incluem levantadores de sobrancelhas internos e externos, rebaixadores, piscadelas, piscadelas e franzimentos labiais, funilizadores, pressores e sucções. O programa padrão da Affectiva examina cerca de 15 destes a qualquer momento e analisa-os para expressões de sete emoções básicas: felicidade, tristeza, surpresa, medo, raiva, nojo e desprezo, além de interesse e confusão. Sorria, e você pode ver a medida da felicidade disparar; enrole o lábio em um sorriso de escárnio e o programa mostra seu desgosto.

Ou, mais precisamente, sua expressão de nojo. Toda a premissa da computação afetiva repousa sobre o que significa um salto de fé, que um sorriso transmite um sentimento de felicidade, prazer ou diversão. É claro que os seres humanos estão na mesma posição: podemos ser enganados por um sorriso falso ou por uma raiva fingida, por isso não podemos esperar mais de um programa de computador, pelo menos por enquanto.

Com o tempo, a Affectiva construiu um arquivo com mais de três milhões de vídeos de rostos, enviados por usuários da Internet recrutados em cerca de 75 países em todo o mundo. Centenas de milhares delas foram analisadas por observadores treinados e codificadas para unidades de ação FACS - um empreendimento monumental, já que os vídeos têm em média 45 segundos e cada um leva cerca de cinco vezes mais tempo para ser processado. Os resultados dos codificadores humanos, por sua vez, foram usados para “treinar” os algoritmos da empresa, que processavam o restante em tempo real. O banco de dados inteiro agora compreende cerca de 40 bilhões de “pontos de dados emocionais”, um recurso que se distingue da Affectiva de outras empresas do mesmo ramo, como a Emotient, com sede na Califórnia, provavelmente seu concorrente mais próximo.

(Gráfico: Infografia 5W; Fonte: Daniel McDuff, Laboratório de Mídia do MIT, Affectiva)

(Gráfico: Infografia 5W; Fonte: Daniel McDuff, Laboratório de Mídia do MIT, Affectiva) Daniel McDuff, que ingressou na Affectiva no MIT Media Lab e atua como diretor de pesquisa, está continuamente estudando esse tesouro para obter insights adicionais sobre a expressão das emoções. Como eles diferem por idade, gênero e cultura? (Talvez surpreendentemente, McDuff descobriu que os idosos são mais expressivos, especialmente de emoções positivas, do que os mais jovens). Podemos medir com segurança o desprezo, o constrangimento, o tédio, a ansiedade? Quando um sulco na testa sinaliza confusão e quando indica concentração? Como podemos distinguir entre uma expressão de medo e uma que significa surpresa? (Dica: a unidade de ação 1, o “levantador interno de sobrancelhas”, é o marcador de medo; a unidade de ação 2, o “levantador de sobrancelhas”, indica surpresa.) Há todas as razões para acreditar que o programa continuará. para ficar melhor em detectar expressões (embora nunca possa superar completamente o maior obstáculo de todos: o Botox).

A meu pedido, McDuff deu ao programa um dos grandes problemas clássicos da detecção de emoções, a Mona Lisa, cujo enigmático sorriso quase intrigou os espectadores por 500 anos. Com a ressalva de que o software funciona melhor na mudança de expressões, não imagens estáticas, ele relatou que não encontrou nenhuma evidência de um sorriso genuíno de La Gioconda, mas sim uma combinação de unidade de ação 28 (rolo de lábios) e 24 (lábios pressionados), possivelmente sugerindo algum nível de desconforto.

**********

"Estou falando com você agora", diz ele, "e observando você para avaliar seu interesse pelo que estou dizendo. Devo desacelerar e explicar mais? Eu deveria ir para outro tópico? Agora, imagine que estou dando um seminário on-line para um grande grupo que não posso ver nem ouvir. Não obtenho feedback, não há como saber se uma piada funcionou ou não, se as pessoas estão envolvidas ou entediadas. Não seria ótimo receber esse feedback em tempo real, agregado, de momento a momento?

Ela faz um anúncio para Jibo, um "robô social" disponível para pré-venda no site de crowdfunding Indiegogo e desenvolvido por uma ex-colega do MIT, Cynthia Breazeal. Parecendo uma espécie de lamparina de lava de alta tecnologia, Jibo se senta em uma mesa e examina os arredores, identificando os indivíduos pelo rosto e interagindo com eles - transmitindo mensagens, emitindo lembretes, fazendo ligações telefônicas de rotina, até mesmo conversando. Esta é outra aplicação potencial para o software da Affectiva - as empresas estão em conversações - e é "uma perspectiva muito interessante", diz El Kaliouby.

Emocionante para alguns, mas a perspectiva de robôs de processamento de emoções é alarmante para os outros. Sherry Turkle, que há muito estuda como os humanos se relacionam com os computadores, adverte em seu novo livro, Reclaiming Conversation: The Power of Talk em uma era digital, sobre o "momento robótico", quando as máquinas começam a substituir a companhia humana. Turkle acredita que cientistas como El Kaliouby e sua equipe podem fazer o que eles dizem que vão. “São pessoas brilhantes e talentosas que fazem um trabalho brilhante”, diz ela. E ela concorda que, em certos contextos - ambientes perigosos, como o espaço sideral ou em torno de maquinário pesado, nos quais você deseja recorrer a todos os modos possíveis de comunicação - a computação afetiva tem um papel a desempenhar. “Mas o próximo passo”, diz ela, “não segue de todo. O próximo passo é: Vamos fazer um robô amigo. Eu entrevistei pais que estão felizes que seus filhos estão conversando com Siri, e acho que isso não está nos levando por uma estrada onde queremos ir. Nós nos definimos como seres humanos por quem nos associamos, e não faz sentido para mim formar seu senso de auto-estima em relação a uma máquina. Por que você quereria um computador para saber se você está triste? ”

Até mesmo El Kaliouby está inclinado a concordar que "estamos gastando mais tempo do que deveríamos com nossos aparelhos", tendo em mente, naturalmente, sua filha pré-adolescente, cujo olhar se fixa na tela do smartphone.

Mas ela considera a tendência para uma conectividade cada vez maior como irreversível, e ela acha que, embora os usuários devam sempre ter que optar por ela, é melhor que façamos o melhor possível. Ela prevê que nossos dispositivos terão “um chip de emoção e um pacote de aplicativos que o usam de uma forma que agrega valor suficiente às nossas vidas, superando as preocupações das pessoas em compartilhar esses dados”. Ela faz uma analogia aos dispositivos GPS: computação afetiva pode Ajude-nos a navegar pelo espaço emocional da mesma maneira que os aplicativos de telefone nos ajudam a se locomover no espaço físico. “Todos também se preocuparam com os dispositivos de detecção de localização quando saíram pela primeira vez: eles estavam invadindo nossa privacidade, estavam nos rastreando o tempo todo”, diz ela. “Somente agora, todos ficaríamos perdidos sem o Google Maps em nossos telefones. Eu acho que isso será o mesmo.

**********