É difícil argumentar contra o poder da ciência. De estudos que avaliam a última tendência dietética a experimentos que iluminam os preditores da felicidade, as pessoas passaram a ver cada vez mais os resultados científicos como fatos concretos e confiáveis que podem governar a forma como pensamos e agimos.

Conteúdo Relacionado

- Cientistas replicaram 100 estudos de psicologia, e menos do que a metade obteve os mesmos resultados

Mas nos últimos anos, um crescente contingente de cientistas começou a questionar a veracidade aceita das pesquisas publicadas - mesmo depois de eliminar os obstáculos da revisão por pares e aparecer em periódicos amplamente respeitados. O problema é uma incapacidade generalizada de replicar uma grande proporção dos resultados em várias disciplinas.

Em 2005, por exemplo, John Ioannidis, professor de medicina na Universidade de Stanford, usou várias simulações para mostrar que as afirmações científicas são mais prováveis de serem falsas do que verdadeiras. E no verão passado, Brian Nosek, professor de psicologia da Universidade da Virgínia, tentou reproduzir os resultados de 100 estudos de psicologia e descobriu que apenas 39% dos resultados resistiam a rigorosos testes.

"Existem várias linhas de evidência, tanto teóricas quanto empíricas, que começaram a questionar a reprodutibilidade de um segmento substancial da literatura científica", diz Ioannidis. "Estamos recebendo milhões de documentos que vão a lugar nenhum."

Essas descobertas preliminares geraram a criação de um campo inteiramente novo chamado meta-pesquisa - o estudo científico da ciência.

Esta semana, o braço de biologia da Public Library of Science (PLOS), uma editora sem fins lucrativos e organização de advocacia, lançou uma nova seção dedicada exclusivamente a meta-pesquisa. A seção irá explorar questões como transparência na pesquisa, padrões metodológicos, fontes de preconceito, compartilhamento de dados, financiamento e estruturas de incentivo.

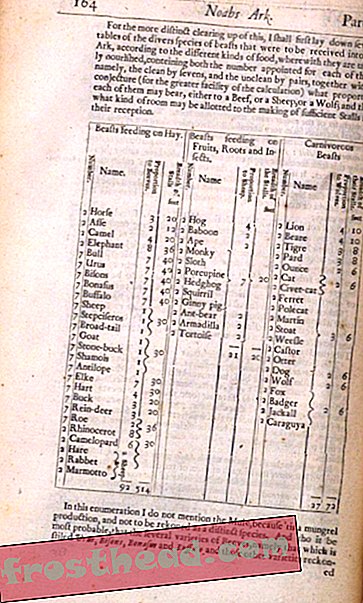

Para dar o pontapé inicial, Ioannidis e seus colegas avaliaram uma amostra aleatória de 441 artigos biomédicos publicados entre 2000 e 2014. Eles verificaram se esses documentos forneciam acesso público a dados brutos e protocolos experimentais, foram replicados em estudos subsequentes, tiveram seus resultados integrados em revisões de uma área temática e incluiu a documentação de fontes de financiamento e outros potenciais conflitos de interesse.

Seus resultados foram preocupantes para dizer o mínimo. Por exemplo, apenas um estudo forneceu protocolos experimentais completos e zero estudos forneceram dados brutos diretamente disponíveis.

"Estes são dois pilares básicos de reprodutibilidade", diz Ioannidis. “A menos que os dados e o protocolo completo estejam disponíveis, não é possível reproduzir nada.” Afinal, sem essas informações-chave, como uma outra equipe pode saber exatamente o que fazer e como os resultados diferem dos do experimento original?

A equipe também descobriu que as alegações de apenas oito dos artigos pesquisados foram posteriormente confirmadas por estudos subsequentes. E apesar de muitos dos estudos afirmarem ter descobertas inovadoras, os resultados de apenas 16 artigos foram incluídos em artigos de revisão posteriores, que servem como um teste decisivo para o verdadeiro impacto de um estudo sobre um determinado assunto.

"Os números que recebemos são muito assustadores", diz Ioannidis. "Mas você pode ver isso como uma linha de base de onde estamos agora, e há muito espaço para melhorias."

No entanto, nem todos os resultados foram desanimadores. A porcentagem de artigos sem declaração de conflito de interesse diminuiu de 94, 4% em 2000 para 34, 6% em 2014 - provavelmente como resultado de uma crescente conscientização dos efeitos perniciosos do viés nos resultados da pesquisa.

Em um segundo estudo de meta-pesquisa, uma equipe alemã analisou como a perda de animais durante experimentos pré-clínicos pode contribuir para a incapacidade generalizada de traduzir os achados laboratoriais em drogas clínicas úteis.

Os animais de pesquisa podem desaparecer de um estudo aleatoriamente - por exemplo, porque o animal morreu - ou por meio de ações sutilmente tendenciosas, como a remoção do teste para eliminar dados que prejudicam os resultados esperados. A equipe demonstrou que a remoção tendenciosa de indivíduos animais pode distorcer os resultados e aumentar significativamente a probabilidade de um falso positivo - quando se pensa que um novo medicamento funciona, mas na verdade não o faz.

Em uma análise separada de estudos pré-clínicos sobre AVC e câncer, os mesmos pesquisadores descobriram que a maioria dos artigos não relatou adequadamente a perda de animais, e que os efeitos positivos de muitos medicamentos testados podem ser muito superestimados.

Então, por que essa crise de transparência e reprodutibilidade está acontecendo em primeiro lugar?

Embora algumas questões possam estar nos vieses de pesquisa conscientes ou inconscientes, é provável que a maioria dos estudos que chegam à publicação sejam únicos, devido à atual estrutura de incentivos da ciência.

No mundo da academia, a principal medida de sucesso é o número de estudos que um pesquisador obtém em periódicos de prestígio. Como resultado, os cientistas estão sob pressão para passar a maior parte do tempo obtendo os tipos de resultados inovadores com maior probabilidade de serem publicados.

"Embora valorizemos a reprodutibilidade em conceito, não valorizamos isso na prática", diz Nosek, que também é co-diretor do Center for Open Science, uma startup de tecnologia sem fins lucrativos que trabalha para promover transparência e reprodutibilidade em pesquisa científica.

“Os verdadeiros incentivos que impulsionam meu comportamento como cientista são inovar, fazer novas descobertas e abrir novos caminhos - não para repetir o que outros fizeram. Essa é a parte chata da ciência ”.

Os cientistas também vêem poucos incentivos para fornecer as informações necessárias para que outros possam replicar seu trabalho, o que é uma das principais razões pelas quais as alegações de tantos estudos permanecem sem verificação.

“Eu não sou recompensado por disponibilizar meus dados ou soletrar minha metodologia com mais profundidade do que o necessário para entrar em uma publicação”, diz Nosek.

Muitas revistas pedem aos cientistas que forneçam uma explicação detalhada de seus métodos e compartilhem dados, mas essas políticas raramente são aplicadas e não há padrões universais de publicação.

“Se eu soubesse que nunca haveria policiais nas estradas, eu sempre manteria o limite de velocidade? Não - é a natureza humana ”, diz Ivan Oransky, co-fundador da Retraction Watch, uma organização que promove a responsabilidade e a transparência rastreando as retratações na literatura científica. "Se você sabe que ninguém vai sancioná-lo, então você não vai compartilhar dados."

Os cientistas que querem realizar trabalhos de replicação e são capazes de obter detalhes experimentais são improváveis de encontrar financiamento de órgãos públicos como o NIH, que julgam principalmente os pedidos de subsídio com base na novidade e inovação.

"As chances são claramente contra a replicação", diz Ioannidis.

É aí que o campo emergente da meta-pesquisa pode intervir. Organizações como o Centro de Ciência Aberta e o Centro de Inovação de Meta-Pesquisa em Stanford (METRICS) estão trabalhando para ajudar a realinhar o sistema de recompensas e estabelecer padrões universais rigorosos que encorajem práticas de transparência e reprodutibilidade.

“Se os níveis de financiamento ou promoção dependessem do que aconteceu com sua pesquisa anterior - se fosse replicável, se as pessoas pudessem entender, se as pessoas pudessem traduzi-lo para algo útil, em vez de apenas quantos artigos você publicasse - isso seria um incentivo muito forte para mudar a pesquisa para se tornar mais reprodutível ”, diz Ioannidis, que é co-diretor da METRICS.

"Espero que esses indicadores melhorem", acrescenta ele. “E para alguns deles, não há outra possibilidade senão subir, porque começamos do zero.”