Como o Memorial Day nos lembra todos os anos, a guerra não vai embora.

Mas isso muda. E uma das mudanças mais profundas que veremos nos próximos anos é para um exército cada vez mais dependente de robôs. Os drones recebem a maior parte da atenção agora, mas cada vez mais as inovações do Departamento de Defesa são outros tipos de máquinas não tripuladas, de aeronaves experimentais a soldados em terra.

É fácil entender a atração. A utilização de robôs é potencialmente mais eficiente, mais precisa e menos dispendiosa do que confiar apenas em seres humanos na guerra. E também significaria, é claro, menos baixas humanas.

Mas essa transformação traz consigo um desafio complexo: as máquinas militares podem ser programadas para tomar decisões? O que leva a uma questão mais complicada: robôs podem aprender moralidade?

O Escritório de Pesquisa Naval dos EUA acha que agora é a hora de descobrir. No início deste mês, anunciou uma doação de US $ 7, 5 milhões de cinco anos para financiar pesquisas nas universidades Tufts, Brown, Yale e Georgetown e no Rensselaer Polytechnic Institute (RPI) sobre se as máquinas podem um dia escolher o certo ou o errado.

A Marinha quer evitar a situação que o carro sem motorista do Google enfrenta agora: ter uma tecnologia lançada muito antes de qualquer esclarecimento sobre as questões legais e éticas que ela levanta. Antes que os robôs autônomos saiam para o campo, os militares querem saber se podem realmente aprender a fazer a coisa certa.

Como diz Selmer Bringsjord, chefe do Departamento de Ciência Cognitiva da RPI, a inteligência artificial de um robô poderia ser projetada para funcionar em dois níveis de moralidade. O primeiro seria baseado em uma lista de escolhas éticas claras, como “se você se deparar com um soldado ferido, você deve ajudá-lo”. Mas e se essa ação entrar em conflito com sua missão principal, como entregar munição criticamente necessária? outros soldados? Nesse ponto, diz Bringsjord, o robô precisaria ter a capacidade de se envolver em “raciocínio moral mais profundo” para tomar decisões em situações que seus programadores talvez não pudessem prever.

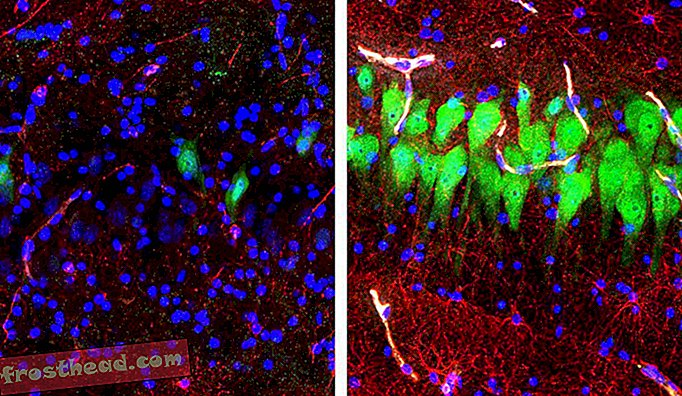

Os pesquisadores precisariam desenvolver algoritmos e mecanismos computacionais únicos que pudessem ser integrados à arquitetura existente de robôs autônomos, um "processo de pensamento" que permitiria que uma máquina sobrepuje o comportamento planejado com base em sua capacidade de aplicar o raciocínio moral.

Se isso parece extraordinariamente ambicioso, bem, é. Para começar, os pesquisadores precisarão isolar os elementos básicos da moralidade humana - com base nos quais todos os princípios concordam? - e depois descobrir como incorporá-los em algoritmos que dariam aos robôs algum nível de competência moral.

Isso não é uma tarefa pequena. Por essa razão, é provável que máquinas não controladas por seres humanos, no futuro previsível, sejam limitadas a funções que não sejam de combate, como vigilância, segurança, busca e salvamento ou assistência médica. Mas, inevitavelmente, os planejadores militares vão querer uma resposta para a questão que paira sobre tudo isso: os robôs, agindo por conta própria, devem ser autorizados a matar um humano?

Se uma máquina tem 90% de certeza de que todos em um veículo que pretende atirar é um terrorista, isso é certo? Um robô seria capaz de disparar uma arma contra uma criança se ela determinasse que é o inimigo? Se algo der errado e um robô autônomo explodir erroneamente uma aldeia, quem é o responsável? O comandante que ordenou a operação? A pessoa que programou o robô? Ou ninguém?

Se você acha que isso ainda é assunto de ficção científica, considere que no início deste mês especialistas em assuntos que vão desde inteligência artificial a direitos humanos e direito internacional pesaram sobre “robôs assassinos” em uma conferência das Nações Unidas em Genebra. Grupos como a Human Rights Watch e autoridades de vários países, incluindo Paquistão, Egito, Cuba e o Vaticano, pediram uma proibição total dos robôs com autoridade para matar. Mas a maioria dos países, particularmente aqueles com os robôs mais avançados, não estão prontos para ir tão longe.

Dê uma olhada, por exemplo, no WildCat, um robô de quatro patas sendo desenvolvido para rodar em alta velocidade em todos os tipos de terreno.

Por enquanto, os militares dos EUA seguem uma diretriz do Departamento de Defesa de 2012 de que nenhuma máquina com o poder de matar pode ser totalmente autônoma. Um humano tem que, literalmente, dar as ordens. Mas isso pode não ser verdade em todos os lugares: em março, a New Scientist citou uma autoridade russa dizendo que sentinelas de robôs em cinco instalações de mísseis balísticos serão capazes de detectar e destruir alvos sem que um humano dê sinal verde.

O Foster-Miller Talon, visto abaixo, é uma das muitas máquinas em todo o mundo sendo desenvolvidas para combate.

Regras de guerra

Um relatório sobre a conferência de robôs assassinos será apresentado ao Comitê de Certas Armas Covertas da ONU em novembro. Mas não parece que a proibição esteja chegando em breve.

Entre os participantes da discussão em Genebra estava Ronald Arkin, um especialista em inteligência artificial da Georgia Tech, que há muito tempo é defensor de dar às máquinas a capacidade de tomar decisões morais. Ele acredita que, se os robôs podem aprender a seguir as leis internacionais, eles podem se comportar de forma mais ética do que os humanos na guerra, porque seriam infalivelmente consistentes. Eles não seriam capazes de reagir com raiva ou com pânico ou preconceito. Assim, Arkin se opõe a uma proibição, embora esteja aberto a uma moratória sobre armas autônomas, até que as máquinas tenham a chance de ver se podem dominar as regras da guerra.

Outro cientista da IA, Noel Sharkey, que debateu Arkin em Genebra, é de uma mente muito diferente. Ele não acha que os robôs deveriam receber a autoridade para tomar decisões sobre a vida ou a morte.

Recentemente ele disse ao Defense One : “Eu não acho que eles nunca vão acabar com um robô moral ou ético. Para isso, precisamos ter agência moral. Para isso, precisamos entender os outros e saber o que significa sofrer ".

"Um robô pode ser instalado com algumas regras de ética, mas não vai se importar", diz ele.